Le SEO reste l’un des leviers les plus efficaces du marketing digital. D’une part, que les clients soient des pros ou des particuliers, ils accèdent en général à l’information en ligne via un moteur de recherche. D’autre part, Google (92% de part de marché de la recherche en ligne en France en 2017) c’est, en moyenne plus de 50% du trafic d’un site, et cela peut monter à 80%. Le SEO est le levier le plus efficace pour que ceux (en BtoB ou en BtoC) qui ont besoin de vos produits ou services puissent vous trouver, savoir que vous existez, vous contacter et in fine acheter vos produits ou services. L’usage de la data en SEO booste son efficacité.

J’irais presque jusqu’à dire que chacun a sa manière de faire du référencement. Certains prestataires se reposent essentiellement sur les aspects techniques. D’autres (très nombreux) travaillent sur le netlinking. Enfin, certains se reposent davantage sur les liens (entrants et internes). J’ai publié un article récemment qui explique comment bien choisir son consultant SEO et comment analyser les performances d’un prétendant “expert” du référencement.

Comment nous faisons du SEO

Depuis 2009 que je suis impliqué dans le marketing digital et donc, entre autres, sur ces sujets (référencement naturel, référencement Google, SEO…), avec mon équipe, nous privilégions le contenu et sa qualité. Nous développons des sites, nous faisons des audits et du conseil, nous corrigeons les aspects techniques si nécessaire. Nous faisons aussi du netlinking, “à la main” et pas en soumission automatique à des centaines d’annuaires, des liens de qualité plus qu’en quantité. Mais notre vraie spécificité, notre valeur ajoutée et notre différence, c’est clairement le contenu.

Nous produisons du contenu qui répond à des enjeux business, de notoriété, de référencement, de génération de leads… Nous produisons du contenu pour qu’il soit référencé par les moteurs de recherche. Le référencement n’est pas une fin en soi. C’est un moyen, au service d’un objectif (développement de business, génération de leads, acquisition de prospects…).

Pour faire du contenu, nous ne nous sommes pas basés sur des formations. Nous avons beaucoup lu et surtout, nous avons cherché à comprendre comment ça marche. Puis nous avons développé notre propre méthodologie. Nous l’avons mise en place en 2010/2011. Nos clients de l’époque sont encore très visibles, malgré les nombreux changements de Google.

Cas Organisme de Formation : coût d’acquisition divisé par 7

Akor (organisme de formation) est toujours référencé sur près de 9 000 mots clés pertinents (cela veut dire que le site ressort dans les 100 premiers résultats sur Google pour près de 9 000 requêtes différentes). Outre un impact conséquent sur son trafic, cela a surtout permis à l’organisme de baisser son coût d’acquisition de plus de 60€ (notamment avec Adwords) à moins de 10€. Parmi ces 9 000 requêtes, le site est, encore aujourd’hui, en position 1 à 3 pour près de 350 mots clés et en première page pour près de 900 au total. Depuis 2014, le site reste bien positionné sur des requêtes telles que :

- bts muc alternance (plus de 660K résultats).

- bts banque alternance (360k résultats).

- bts en alternance (12M résultats).

- bts nrc alternance (275K résultats).

- bts alternance (12.5M résultats).

Cas d’un Cabinet d’Outplacement

Autre exemple : humanfirst, cabinet d’outplacement.

Là encore, le site reste présent aujourd’hui sur des requêtes concurrentielles telles que cabinet outplacement / cabinet d’outplacement / outplacement cadre dirigeant / outplacement dirigeant / outplacement paris.

Ces 2 sociétés ont décidé d’intégrer la prestation de SEO et ne sont plus clientes. Néanmoins, ces 2 exemples, montrent que nos résultats sont pertinents et pérennes.

DATA & SEO en Gestion privée

L’an dernier, suite à un article de mon blog que je relaie sur LinkedIn, je suis contacté par un des associés de Lonlay & Associés. C’est une société de gestion privée basée à Paris 8°. L’approche que j’ai décrite dans un article l’intéresse et il veut la mettre en place pour son cabinet. Entre les banquiers, les assureurs et les sociétés spécialisées, la gestion privée est un marché concurrentiel. Et Lonlay n’a ni la notoriété ni les budgets de groupes financiers ou média comme Allianz, Le Figaro, Axa, Capital (pour reprendre quelques institutionnels présents en 1° page des résultats de Google).

1° étape : analyse de la demande

L’une des choses que j’ai apprises depuis que j’interviens dans le digital, c’est que si les dirigeants et les marketers connaissent bien leurs marchés et leurs clients, ils ne connaissent pas, peu ou mal leurs marchés on line. Très peu de dirigeants sont donc en mesure de faire une sélection réellement pertinente des mots clés sur lesquels se positionner. Cela se fait au feeling, suite à un brainstorming. Aucun moyen d’être sûr d’être sur les bonnes requêtes.

Pour moi, ce n’est pas à un client de dire quelles sont les requêtes cibles sur lesquelles il veut rendre son site visible. C’est au prestataire de lui donner des éléments sur son marché en ligne, la demande, la concurrence… pour qu’il puisse le faire.

Pour cela, il existe de nombreux outils de Google (Analytics, Search Console, trends, keyword planner…). Ces outils ont l’avantage d’être gratuits. Ils ont aussi l’inconvénient d’être gratuits. Les utiliser, c’est mieux que de rien faire, mais ce qu’on peut en tirer est vraiment très basique. J’ai pourtant vue des recommandations de prestataires basées uniquement sur ces outils ! Qu’on les utilise soi-même pourquoi pas, mais qu’une recommandation de prestataire repose sur les données de ces outils ne me parait pas très professionnel.

Nous utilisons d’autres outils (des outils data), payants, chers, mais nettement plus puissants. Résultat, quand Google Keyword Planner remontait 585 requêtes d’internautes sur lesquelles se référencer, nous en avons trouvé 17 571. La différence est énorme (30 fois plus). Ce qui est clair, c’est qu’avec près de 18 000 requêtes différentes, notre client a une connaissance très précise de la manière dont, sur Internet, on recherche ses produits et services. Bien plus précise qu’avec les 571 suggestions de Google Keyword Planner.

Google précise que la demande globale autour de la thématique, c’est entre 1 et 10 millions de recherches par mois en moyenne. Nous savons précisément que la demande est de l’ordre de 2.8 millions de recherches mensuelles en moyenne. Dans ce cas, l’information n’est pas indispensable mais quand on doit faire un choix entre plusieurs segments ou plusieurs niches, il est plus efficace de savoir quelle est la taille de chaque segment plutôt que de savoir que pour tous les segments il y a entre 1 et 10 millions de recherches par mois. Dans ce cas, difficile de prioriser et de faire des choix.

Le client a la liste des 17 571 requêtes différentes. Pour chaque requête, nous indiquons le volume moyen de recherches mensuelles et quelques autres informations.

A ce moment-là, et à ce moment-là seulement, c’est à notre client de choisir les mots clés qu’il veut cibler et sur lesquels positionner son site. A ce stade, il le fait en connaissance de cause, en ayant une étude de marché précise.

2) recherche des mots clés à mettre dans les textes

Notre client connait maintenant son marché en ligne. Nous ajoutons une analyse de la stratégie de quelques concurrents. Il nous indique ensuite quelles sont ses cibles. On peut donc envisager une stratégie de type “Océan Bleu” : cibler des segments de marché pour lesquels il y a une demande élevée et une concurrence modérée.

On refait une analyse data, de chacune des cibles choisies, pour essayer d’identifier les mots clés que les moteurs de recherche s’attendent à trouver dans des articles pour les considérer comme pertinents et donc pour les référencer en bonne position. Là encore, notre approche data et les outils que nous utilisons sont très utiles, même s’il y a beaucoup de travail manuel.

3) rédaction d’articles optimisés

Je ne vois pas l’intérêt de déployer une stratégie éditoriale online sans intégrer le référencement et donc sans prendre en compte le mode de fonctionnement des moteurs de recherche et notamment de Google.

Ecrire pour les réseaux sociaux, c’est bien. Ecrire pour les humains, c’est bien. Mais si on veut toucher des êtres humains, il faut impérativement prendre en compte le SEO. Miser sur une hypothétique viralité social media, c’est s’exposer à de grosses désillusions. Comme indiqué dans un article de la Harvard Business Review France (Août Septembre 2016) : “l’idée même que les consommateurs voudraient discuter de Corona ou de Coors de la même manière qu’ils débattent du talent de Ronaldo et Messi est complètement absurde”.

Les réseaux sociaux sont des outils très efficaces en communication, pour du branding, pour de la notoriété. D’un point de vue purement business, “bottom line”, toutes les études montrent que c’est moins évident.

Notre objectif, quand nous rédigeons des articles pour des clients c’est que ces articles soient référencés et apportent du trafic. Un article, c’est une journée de travail à partir d’une analyse data et pour un texte de 1 200 à 1 800 mots, en fonction de chaque marché. L’article de 500 mots, recommandé par certains, cela ne marche pas. Toutes les études sur ce sujet, montrent qu’un contenu bien référencé, c’est aussi un contenu qui est long.

4) Résultats

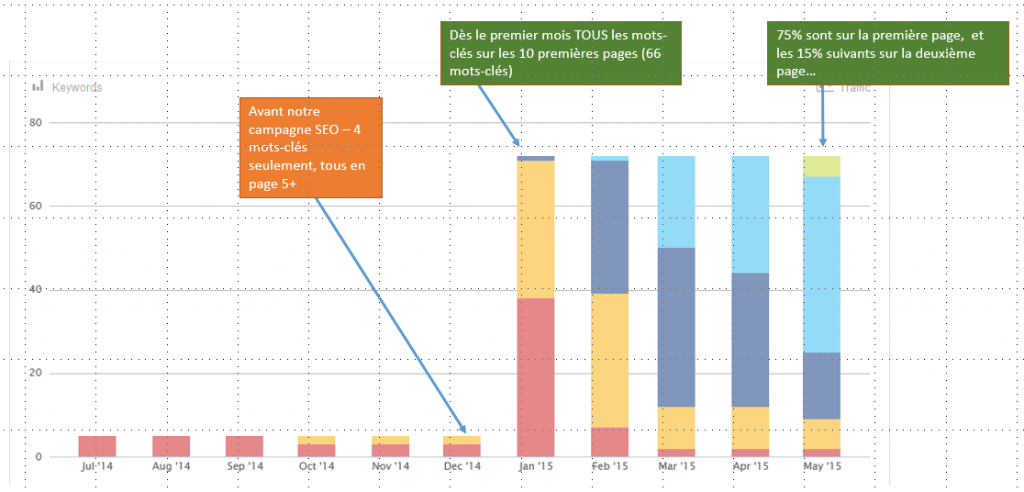

Nos résultats sont rapides, mais ils s’observent en 2 temps. Dans un premier temps, les sites sur lesquels nous travaillons sont visibles (référencés) sur un nombre croissant de mots clés. La visibilité potentielle augmente. Cela veut dire que le site apparait dans les 10 premières pages de résultats pour un nombre croissant de mots clés. Mais le site peut ressortir en 3°, 5°, 8° page et donc avec un impact très limité sur le trafic du site.

Dans un 2° temps, ce nombre de mots clés continue d’augmenter et les positions moyennes augmentent. Au lieu de sortir en 3° ou 8° page sur des requêtes d’internautes, on sort en 2° et 4° page. Dans ce 2° temps, on commence à avoir un impact sur le trafic du site.

En moyenne, il nous faut 3 mois pour commencer à avoir un impact réellement significatif sur le trafic du site.

On le voit bien sur ce diagramme : ce sont d’abord le rouge et le jaune qui augmentent : le site ressort sur plus de mots clés mais en pages 5 et au-delà. Progressivement, ce sont le bleu et le vert qui augmentent : le site ressort dans les premiers résultats.

A ce stade, toujours pas de lien entrant. Les articles sont référencés uniquement sur la qualité du contenu. Les liens entrants sont envisagés dans une 3° phase, pour se rendre visible sur les mots clés ciblés et non encore atteints.

Concernant Lonlay & Associés, quand nos articles ont mis en ligne, le site, créé en 2010, est référencé (il ressort dans les 100 premières positions) pour un peu plus de 130 mots clés.

Nous mettons en ligne une dizaine d’article. Nous avons des premiers résultats en quelques jours. En 7 semaines, le site passe à 944 mots clés. C’est-à-dire *7. En quelque semaines, nous avons multiplié par 7 le nombre de mots clés sur lesquels le site ressort. Tout cela, simplement sur la base de notre approche data et de la qualité du contenu et sans aucun lien entrant.

Nos résultats pérennes s’observent généralement au bout de 3 mois.

Ce résultat n’est pas essentiel. Ce qui compte ce n’est pas d’être positionné sur plus de mots clé, c’est d’être positionné sur les bonnes requêtes, celles que le client a choisies… et celles qui génèrent du trafic.

Les résultats sont au rendez-vous : le trafic quotidien du site a doublé en quelques jours.

Pour plus d’infos, des questions, un audit de votre visibilité ou d’un site concurrent : cyril.bladier@business-on-line.fr / 06.42.67.30.43.